最近在读 卡尔.纽波特的 深度工作, 以下是阅读的一点感悟和笔记.

深度工作是 21 世纪的超级力量

作者介绍: 卡尔·纽波特,畅销书作家,人气博主,创办了在美国很受欢迎的博客“学习黑客”,破解工作和学习领域的成功模式。

关于本书 这是一本自我管理类书籍,讲述了在碎片化时代,如何训练大脑排除干扰,提高大脑的深度思维能力,创造更多价值。这本书的英文原版2016年在美国出版,一发行就占据了亚马逊美国网站的职场励志书榜首。

几个问题:

在职场中,为什么有些人越忙碌越无法产出有价值的成果? 又该如何通过训练大脑排除干扰,提高深度思维能力,创造更多价值? 这本书从2个方面解释了大部分人无法进行深度工作的原因,并给出了培养深度工作的4个步骤,分别是:

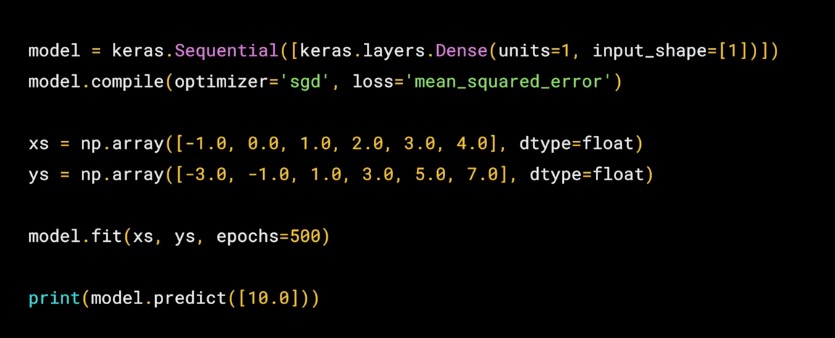

选择适合自己的深度工作模式 将工作内化成习惯 像经商一样去执行 适当减少整体工作时间遵循这几个步骤进行刻意练习 概念介绍 深度工作(Deep Work): 在没有干扰的情况下专注的进行职业活动, 使个人的认知能力达到极限, 这种努力能够创造新价值, 提升技能, 而且难以复制.

肤浅工作(shallow work): 对认知要求不高的任务, 在收到干扰的情况下也能进行, 此类工作创造的价值不高, 且容易复制.

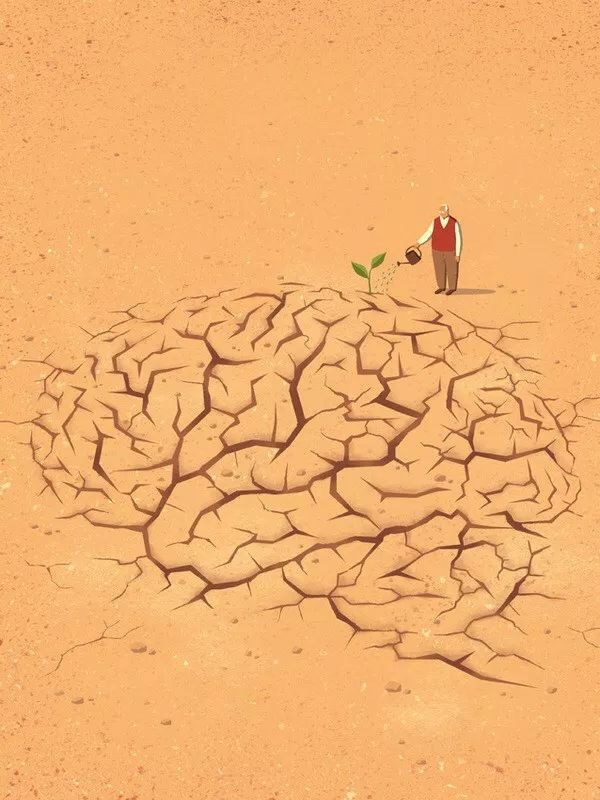

深度工作的重要性 作者前面花了大量篇幅说明深度工作的重要性, 其中关于注意的论断深以为然.

快速学习复杂的技能, 这能为我们带来价值, 这件事需要深度工作.

但是现实生活中, 网络工具使我们分心, 导致专注能力的下降. 不分心是很难的, 我们都有一种冲动就是, 把自己的注意力转移到肤浅的事物上.

比如, 工作累了或者遇到难题了就要刷刷社交网络, 但是这种行为其实还是在消耗着你的注意力和能量. 你的意志力是有限的, 它在使用的过程中是不断的被消耗的. 而进入深度工作状态是需要意志力能量, 如何使得这个转化过程变得容易使我们应该掌握的技巧. 简而言之, 我们增加深度工作的评率, 而减小转移到肤浅工作的冲动和频率. 我们都有过类似的经历, 打开 word 文档, 准备写论文和报告, 一瞬间脑袋空白, 这时候平时不相干的事情, 突然都变得可爱起来, 比如: 洗完, 扫地, 洗衣服, 收拾房间, 下楼买💊, 总之只要是不是写论文, 什么其他能拖延这件事情的事, 我们都愿意干.